O que era pra ser uma ida tranquila ao dentista em uma quarta-feira à tarde acabou se transformando rapidamente em uma espiral de constrangimento e tensão para o auxiliar de logística Natan Silva, de 24 anos. No dia 17 de abril, o jovem foi parado por três agentes da Polícia Militar do Rio de Janeiro (PMERJ) que o abordaram no interior de uma clínica, localizada em Bonsucesso, zona norte da capital.

“Você é o Natan? Tá com documentação aí? Posso te revistar?”, disse o policial, segundo o jovem relatou à Agência Pública. Ele entregou sua identidade em meio a olhares suspeitos dos pacientes dali. Uma testemunha presente no local que não quis se identificar disse à reportagem que, logo após terem conversado rapidamente com a atendente, antes de fazerem a revista, um dos policiais sacou sua arma ali mesmo, na sala de espera.

Os policiais viram o documento e, segundo Natan, ficaram entre eles se perguntando: “Pô, será que é ele mesmo?”. Na escada, os policiais engrossaram, já com a arma nas costas de Natan. “Tem um mandado de prisão contra você. Você está muito encrencado.” Natan colocou a mão na cabeça e foi avisado para não tentar nenhuma “gracinha”.

Já na rua, Natan foi avisado que ele iria se resolver na delegacia mais próxima e colocado na viatura. Natan ousou perguntar como eles sabiam detalhes de sua vida. Os agentes mostraram uma foto que o jovem reconheceu como sendo dele, trajando uma camiseta de um time de futebol e um capacete de motociclista nas mãos. A imagem teria sido tirada uma semana antes.

Os agentes então teriam feito inúmeras ligações e, após algum tempo, o tiraram da viatura. Na calçada, à vista de conhecidos, ele começou a filmar parte da ocorrência e postou em suas redes sociais. Uma amiga advogada passou a orientá-lo remotamente.

Papo vai, papo vem, os policiais finalmente mostraram a foto que motivou a ação: uma imagem de um indivíduo com a cabeça ferida tirada aparentemente dentro de uma delegacia. Natan alegou que aquela pessoa da foto não era ele e, após muita tensão, os agentes aceitaram que ele não era o procurado. Questionados por que eles foram diretamente para ele, os policiais apontaram para uma câmera do outro lado da estação de Bonsucesso.

Por que isso importa?

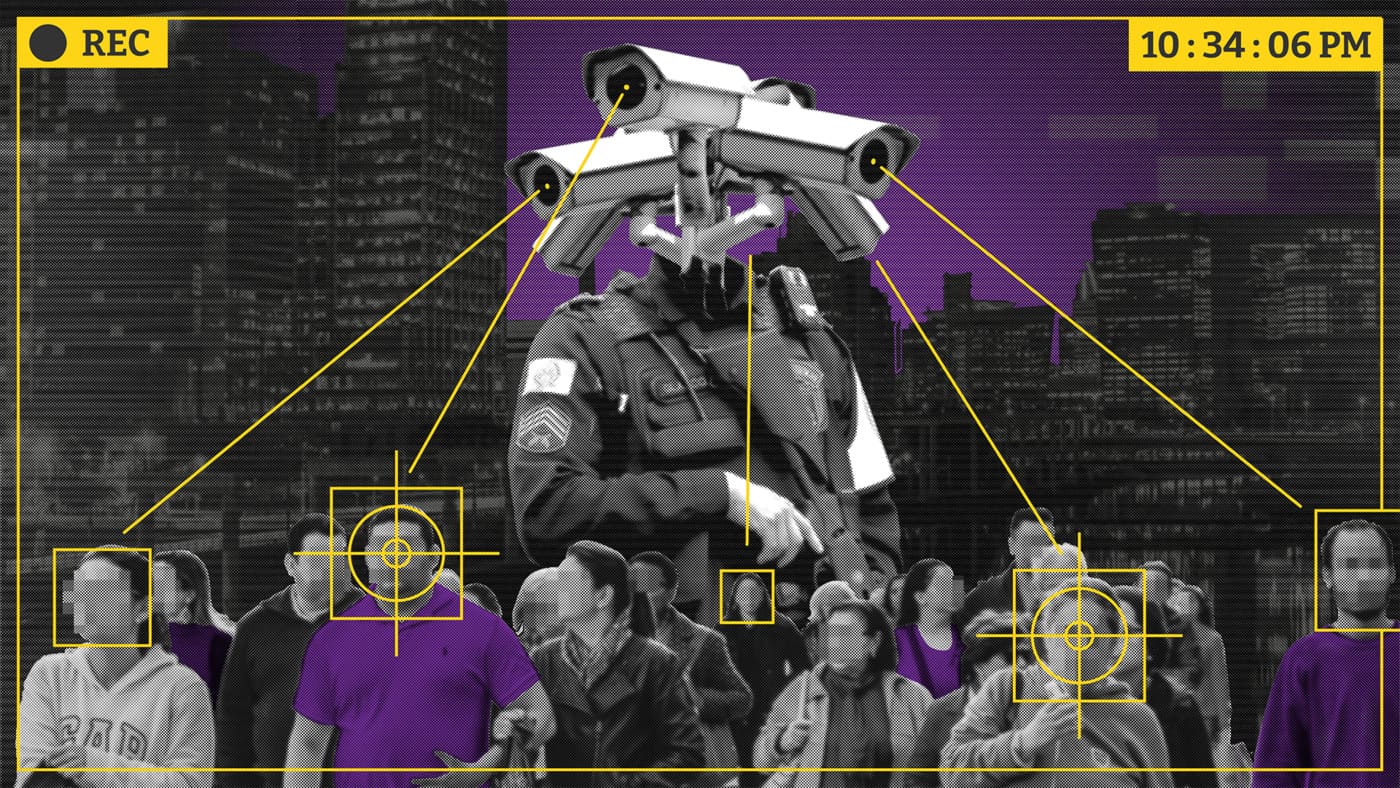

- Tecnologias de reconhecimento facial têm sido usadas por polícias de todo o país sem regulamentação e transparência. Além do risco de prisões injustas, os sistemas lidam com dados sigilosos de milhões de pessoas.

- No Rio de Janeiro, polícias têm usado tecnologias diferentes, há relatos de detenções injustas e consórcio de municípios também possui sistema próprio.

“Você foi filmado por aquela câmera ali. Através do reconhecimento facial a gente identificou você como criminoso”, teria dito o policial. Mesmo após o aparente desembaraço, o policial insistiu em levá-lo para a delegacia, conta Natan, indicando que ele teria uma “divergência em seu CPF”. Ele, receoso, preferiu não aceitar a carona. Pouco depois, assessorado, Natan foi à delegacia e conseguiu resolver sua situação. Os policiais não compareceram para depor, segundo consta no Boletim de Ocorrência.

Uso de câmeras de reconhecimento facial no Rio não segue padrão

O 22° Batalhão, de onde são os agentes que atuaram no caso, opera nos bairros de Benfica, Bonsucesso, Ramos, Manguinhos, Higienópolis, bem como em todo o Complexo da Maré. Em suas redes sociais o batalhão postou, apenas em 2024, outras três situações em que usou – segundo eles, com sucesso – câmeras de reconhecimento facial em sua área de atuação. Uma no dia 28 de março, outra no dia seguinte e a última no dia 14 de abril, alguns dias antes da falha com Natan.

Não há transparência, porém, no que tange a erros da ferramenta. A assessoria da PMERJ disse à Pública que, sobre o caso de Natan, após “análise das equipes do Centro Integrado de Comando e Controle (CICC), não foi localizado registro de acionamento pelo Sistema de Videomonitoramento e Reconhecimento facial na região de Bonsucesso no último dia 17 de abril”.

A aplicação das tecnologias de reconhecimento facial no estado do Rio de Janeiro ocorre sem regulação legal, tal como na esfera nacional. Segundo a Pública apurou, cada uma das polícias, Civil e Militar, utiliza seus próprios softwares e tem seus protocolos altamente flexíveis para lidar com as imagens e as informações geradas pelas máquinas. As instituições não integram seus respectivos sistemas de informação e carecem de controle sistemático por entidades externas.

Além disso, há muitos sistemas dentro do próprio estado. A Baixada Fluminense, por exemplo, conta com um software de reconhecimento facial de uso próprio e desconectado daqueles da capital e do resto da região metropolitana do Rio de Janeiro. Em operação desde 2018, o Consórcio Intermunicipal de Segurança Pública da Baixada Fluminense (CISPBAF) age como uma ilha semiautônoma de segurança pública, com software próprio e zero transparência.

Polícia Militar justificou programa de câmeras após chacina no Jacarezinho

No dia 6 de maio de 2021, 27 civis foram assassinados por agentes de inúmeras delegacias comuns e especializadas da Polícia Civil do Rio de Janeiro no acontecimento que ficou conhecido como chacina do Jacarezinho. O massacre se deu em uma operação policial encabeçada pela Delegacia da Criança e do Adolescente Vítima (DCAV), com suporte de 294 agentes da corporação. Reportagens apontaram que a maioria das mortes tinha sinais de execução, questionando a versão oficial de que foram “reação a injusta agressão”, no jargão policial.

Essa chacina serviu para justificar a ampliação da implementação do sistema de monitoramento por reconhecimento facial da PMERJ. Segundo um documento de 2022, obtido pela Pública por meio do Sistema Eletrônico de Informações do Estado (SEI), a violência na comunidade do Jacarezinho foi utilizada pela polícia como justificativa para a implementação e a ampliação de câmeras de reconhecimento facial. O Jacarezinho, descrito como um lugar muito violento, necessitava de maior presença das autoridades de segurança pública na visão da corporação. A comunidade seria o ponto de partida para a expansão de câmeras de reconhecimento plena pela capital e as cidades adjacentes. À época, o projeto embrionário de reconhecimento facial havia sido implementado apenas no Maracanã e no Aeroporto Santos Dumont, em 2019.

O documento em questão, assinado pela Diretora de Infraestrutura de Tecnologia Major Agdan Miranda Fernandes, afirma que as câmeras serviriam para uma nova pacificação da favela: “A contratação ora pretendida possui relação direta com a atuação emergencial no bairro do Jacarezinho, e as ações futuras pretendidas pelo governo do estado, que terá como ponto de partida a intervenção policial promovida pela Polícia Militar do Estado do Rio de Janeiro e terá como objetivo geral o apoio em inteligência operacional no processo de ocupação e pacificação do território”, diz o documento.

Do final de 2023 até agora, a política de reconhecimento facial espalhou câmeras pela orla e vias expressas da região metropolitana do Rio de Janeiro. Em fevereiro deste ano, algumas dessas câmeras foram furtadas e vandalizadas. Elas são concedidas pela empresa paranaense L8, em um contrato de R$ 18,6 milhões, que vendeu ao estado câmeras da empresa chinesa Hikvision. O modelo em questão, segundo um recurso da SEAL Telecom à derrota no pregão, obtido pela Pública, falha com o critério preestabelecido pelo edital da corporação, que exigia reconhecer no mínimo 40 faces simultâneas: as câmeras da companhia chinesa têm um limite de cinco rostos simultâneos.

O fato foi desconsiderado pela comissão do pregão, que, ao final do mesmo documento, afirmou não haver discrepância entre o apresentado e o exigido na chamada do pregão. Vencedora também da licitação para body cams, de 2021, num contrato de R$ 71 milhões, a L8 já foi alvo de reclamações e processo administrativo pela própria PMERJ em decorrência da qualidade das câmeras corporais dos policiais militares do Rio.

O processo, segundo um despacho interno obtido pela Pública no Sistema Eletrônico de Informações do Estado do Rio, gerou uma multa à L8 no valor de R$ 301 mil.

Programa russo na polícia carioca

Os problemas técnicos e burocráticos, contudo, não se resumem à capacidade das câmeras, mas abrangem também o software usado para reconhecimento facial, o FindFaces, da empresa russa NTech Lab – que tem o governo russo no quadro de investidores.

O FindFaces surgiu em fevereiro de 2016 como um aplicativo de celular, acumulando prêmios, críticas e polêmicas desde seus primórdios. Ainda no primeiro ano de vida, o então app, popular por ajudar a encontrar o nome das pessoas nas fotos nos perfis dos usuários, havia virado notícia por permitir que usuários utilizassem para localizar a identidade de atrizes pornôs a partir de suas imagens online, criando terreno fértil para stalkers.

O aplicativo foi finalizado em 2018, dando espaço para sua aplicação em segurança pública. Segundo um vazamento, o programa teria sido vendido a países como a Rússia e o Brasil, e também a empresas como Dell, Intel e Philip Morris. Na época, o programa foi criticado internacionalmente por ter raça como categoria analítica para identificação de indivíduos, visto que a demarcação de grupos étnico-raciais poderia abrir terreno para perseguição de minorias.

Entre 2021 e 2022, reportagens apontavam o uso do FindFace para localizar e prender participantes de protestos políticos na Rússia. O site oficial da NTech Lab, empresa criadora do programa, afirma que o software armazena apenas informações de procurados pelo Estado, não de transeuntes em geral. Após as críticas, no começo de 2022, Artem Kukharenko e Alexander Kabakov, os sócios fundadores da companhia, abandonaram a empresa, declarando-se contra a guerra contra a Ucrânia e contra o uso repressivo de sua tecnologia pelo governo russo.

A crescente de polêmicas envolvendo a empresa fez com que, em julho de 2023, ela sofresse sanções da União Europeia (UE) sob a justificativa de “ser responsável por prover suporte técnico e material para sérias violações de direitos humanos na Rússia, incluindo prisões e detenções arbitrárias, e violações ou abusos de direitos à liberdade de reunião pacífica e de associação”, segundo relatório da UE.

Embora não haja diretrizes que definam como a Polícia Militar pode utilizar o FindFace, segundo conversa com fonte anônima da Polícia Civil, o uso se reduziria à base de criminosos e suspeitos no status de procurados, sem armazenar dados de indivíduos comuns vivendo suas vidas cotidianamente.

Não há, porém, nenhuma regra que obrigue a Polícia Militar a se ater ao uso da tecnologia apenas para procurados pela Justiça. Atualmente só há uma resolução para a utilização do reconhecimento facial, e ela é exclusiva para a atuação da Polícia Civil. Na prática, os agentes da PMERJ podem abordar indivíduos que “dão match” em tempo real com as câmeras com tecnologia da NTech Lab.

Em resposta, a assessoria da corporação afirmou que há um protocolo de três filtros de abordagem: no primeiro, há a análise inicial do vídeo; a abordagem do agente no terreno vem em seguida; passando à confirmação dos dados e do mandado de prisão em delegacia. Caso não seja a pessoa procurada, esta deveria ser liberada imediatamente.

“Como não existia nenhuma anotação na ficha de Natan, solicitei a liberação dele e o registro de todo ocorrido”, apontou sua defensora, Karla Romão.

O caso dele está longe de ser o único. Recentemente a Comissão de Direitos Humanos da Assembleia Legislativa do Estado Rio de Janeiro (Alerj) atendeu uma psicóloga negra que também foi incorretamente identificada como criminosa. No réveillon, uma mulher foi detida e logo depois solta devido à falta de atualizações do Sistema de Cadastro de Mandados de Prisão da Polícia Civil, baseado em dados do Poder Judiciário.

Em nível internacional, diretrizes da ONU publicadas em 2022 em parceria com diversas polícias mundo afora, incluindo a Polícia Federal, definirem que, em última instância, tais imagens não devem ser usadas como provas, mas como pistas principais para a localização e comprovação posterior da identidade de indivíduos por meio de dados biométricos confiáveis, como a impressão digital.

Resolução da Polícia Civil permite que delegados escolham o que fazer com imagens

No lado da Polícia Civil, a situação também é problemática. Em teoria, toda imagem produzida por uma câmera com ou sem tecnologia de reconhecimento facial deveria passar por uma das perícias da Polícia Civil do Estado do Rio de Janeiro (Pcerj), que são divididas em quatro institutos: Instituto Médico Legal Afrânio Peixoto (IMLAP), Instituto de Criminalística Carlos Éboli (ICCE), Instituto de Identificação Félix Pacheco (IIFP) e Instituto de Pesquisa e Perícias em Genética Forense (IPPGF). Destes, apenas o ICCE e o IIFP lidam com perícias do tipo, o que é, inclusive, objeto de disputa entre os dois setores.

Na prática, contudo, os delegados do Rio de Janeiro podem decidir o que fazer com as imagens que tiverem em mãos. Eles contam com o princípio de autonomia e livre convencimento que permite que o processo de perícia de qualquer prova seja uma opção e não uma obrigação, inclusive para resultados de buscas de câmeras com softwares com reconhecimento facial. Isso é assegurado na Resolução 509 de 2023 da Secretaria de Estado de Polícia Civil (Sepol), a qual explica que os delegados podem mandar as imagens para análise do IIFP e, após os peritos delimitarem um número de suspeitos possíveis, eles podem enviar os resultados para uma análise dos profissionais do ICCE. Ou seja, eles não precisam mandar nada para ninguém se não quiserem.

Isso significa que, se câmeras privadas ou de outros setores do Estado com tecnologia de reconhecimento facial afirmarem que a identidade de um criminoso filmado seria X, o delegado pode simplesmente utilizá-lo como laudo, mesmo que não seja tecnicamente.

A perita criminal Denise Rivera, que por anos trabalhou no ICCE e agora está na Defensoria Pública do Estado, analisa duas situações problemáticas: sobre o uso de imagens de câmeras sem reconhecimento facial: “[nesse caso] o delegado trabalha com o livre convencimento, vamos dizer assim, entre aspas. Acontece muito nas delegacias de homicídio, eles têm uma equipe que bota quadro a quadro, e aí dizem, olha, é fulano. E mandam isso para a Justiça. Manda para o Ministério Público [MP], o MP acha que aquilo ali é laudo, e vai para a Justiça”.

Quanto ao uso de imagens com reconhecimento sem qualquer perícia, ela questiona: “Como é que a gente pode atestar que ele [o vídeo] não foi adulterado? Eu digo, vamos dizer, às vezes a câmera pode estar com uma data errada. Isso acontece às vezes. Ela pode estar com o horário errado. E aí a gente às vezes consegue ver, vamos dizer, por outra câmera, ou às vezes tem algum indício nas imagens que você vê que não é aquele horário que está sendo colocado ali. Mas isso tudo tem que ser analisado de forma criteriosa. E não como fazem. Porque eles querem fazer rápido para poder dar logo uma resposta”, afirma.

Para ela, a falta de obrigatoriedade por perícia cria documentações que deveriam ser consideradas frágeis juridicamente, embora sejam facilmente assimiladas em denúncias e processos por promotores e juízes. Ela crê que a Resolução 509 da Sepol tem que mudar o verbo “poder” para “dever”, forçando o delegado a adotar os critérios básicos indicados pela ONU e, portanto, limitando o número de erros que a polícia pode cometer com reconhecimento facial facilitado ou não por softwares especializados.

Para entender como funcionam as perícias dos resultados gerados pelas tecnologias de reconhecimento facial usadas pela Polícia Civil, a Pública solicitou entrevista com o diretor do Instituto Félix Pacheco. Todavia, a assessoria de imprensa da PCERJ insistiu que a corporação nada tinha a ver com o tema, por mais que, oficialmente, a Polícia Civil faça reconhecimento pós-crime. “O que eu posso te dizer é como é um trabalho que não tem a ver com a gente, como esse trabalho é um trabalho da polícia militar, quem pode falar com vocês é a Polícia Militar. A gente não faz parte desse trabalho. Se a Polícia Militar utilizar o banco de dados do Instituto Félix Pacheco, ainda assim a gente não tem nada a ver com esse trabalho”, explicou a assessoria.

Apesar disso, a Pública conseguiu contato com um perito de um desses institutos que explicou o funcionamento do reconhecimento facial na Polícia Civil e nos guiou pelo prédio, contanto que mantivéssemos sua identidade em anonimato.

Subindo as escadas do Félix Pacheco, no bairro Estácio, na região central do Rio, encontra-se uma pequena sala onde dois peritos trabalham exaustivamente analisando a possibilidade de utilização das imagens de crime no sistema de reconhecimento facial da Montreal Informática, empresa brasileira que oferece ao Detran (cujo sistema é dividido com o IFP) o software ZFace, desenvolvido em solo nacional.

A possibilidade de uso da imagem depende da qualidade desta, ou seja, da iluminação, da pixelagem e das posições do rosto; imagens com baixa definição e clareza tendem a ser dispensadas pelos peritos.

Quando ela é aceita, os dois funcionários destacados para isso ficam em seus computadores comparando todos os candidatos apresentados pelo ZFace a partir da base de identificação civil do Detran até encontrar aquele ou aqueles com maior probabilidade de serem os culpados do crime. Esse processo é importante porque, segundo o perito, é imprescindível lembrar sempre que face não é impressão digital. “Gêmeos têm impressões digitais diferentes, mas têm, descontando eventos individuais, faces iguais.”

Há poucos meses, a Secretaria de Segurança Pública do Rio de Janeiro firmou dois acordos para que a Polícia Civil tivesse acesso também aos softwares de reconhecimento facial e biométrico da Polícia Federal, que usa a Abis (Solução Automatizada de Identificação Biométrica), da gigante latino-americana de tecnologia forense IAFIS System; e do Tribunal Superior Eleitoral (TSE). Com isso, os peritos têm acesso a pelo menos três bases de dados e softwares diferentes, na busca por diminuir os erros na identificação de criminosos.

Consórcio da Baixada usaria tecnologia chinesa para vigilância

Criado em 2018 e composto atualmente por 19 municípios, o Consórcio Intermunicipal de Segurança Pública da Baixada Fluminense (CISPBAF) representa a ponta menos transparente das aplicações de tecnologias de reconhecimento facial para uso policial na região metropolitana do Rio de Janeiro. Desde 2019, o governo estadual sob o comando de Cláudio Castro e a Alerj vêm irmando convênios com o consórcio com o objetivo da formação do Centro Integrado de Comando e Controle (CICC-BF), que hoje funciona no prédio central do CISPBAF, na avenida Brigadeiro Lima e Silva, em Duque de Caxias. Atualmente, só nesse município há 320 câmeras com reconhecimento facial.

A tecnologia do CISPBAF é própria e utilizada pelas polícias Civil e Militar da Baixada. Todavia, não se sabe a forma exata como ela é empregada. O usufruto é evidenciado pelas reuniões recorrentes com os líderes dessas instituições, mirando firmar acordos, ações conjuntas e alinhamento de ideias para “fortalecer a segurança pública na Baixada Fluminense”, como está escrito numa publicação no Instagram oficial do consórcio. Nela, vê-se uma reunião que contou inclusive com a participação de representante da Polícia Rodoviária Federal no Rio de Janeiro (PRF-RJ). Fica esclarecido que as tecnologias de monitoramento do centro integrado estão à disposição das instituições policiais da região.

Isso significa que a Baixada Fluminense produz imagens com tecnologias próprias que não estão ligadas diretamente às centrais das polícias Civil e Militar. Ou seja, o CISPBAF construiu uma forma de autonomia na segurança pública regional, sem envolver diretamente as sedes das corporações e as perícias da PCERJ. Tanto o perito do IFP quanto Denise Rivera, do ICCE, afirmam que as imagens e informações de crimes filmadas e analisadas pelas câmeras de reconhecimento facial do CISPBAF não passam pelos institutos de perícia da Polícia Civil. O que significa que as imagens produzidas pelo consórcio não seriam periciadas.

O CISPBAF tem problemas de transparência não apenas com a própria produção de informações para a Justiça, mas também com o público geral. A sessão de transparência do site não funciona. Todos os botões de “ver mais” são apenas decorativos, sem funcionalidade, o que impossibilita um pedido de informação ou análise de dados abertos.

Após duas semanas sem resposta por email, a Pública foi pessoalmente à sede do consórcio, em Duque de Caxias. Marcamos um encontro que acabou não ocorrendo. Por WhatsApp, tentando remarcar o encontro, pedimos ao pessoal de TI da instituição que nos passasse o nome do software que utilizam nas câmeras das cidades, o que não foi respondido. Ligamos então para a instituição e, após termos retornado o pedido, o telefone ficou mudo. O número da reportagem foi, inclusive, bloqueado pela sede do consórcio. Após um tempo, nos ligaram para explicar que, por mais que, teoricamente, o nome de um software privado contratado por uma instituição pública fosse um dado público, a chefia do CISPBAF precisa dos dados de quem está solicitando a informação para melhor compreender o pedido. Novamente, por WhatsApp, nos foi solicitado que enviássemos um email para o setor jurídico, pois os dados seriam sigilosos.

O pesquisador Rodrigo Raimundo, do Panóptico – grupo de pesquisa que monitora as novas tecnologias de segurança no Brasil –, aponta que o CISPBAF utiliza o sistema de reconhecimento facial da Dahua, empresa chinesa que ocupa o pódio como segunda maior companhia de tecnologia de segurança no mundo. O DSS PRO é um programa de central de monitoramento com reconhecimento facial vendido ao redor do mundo pela Dahua, presente em países como a Sérvia e a própria China.

A gigante chinesa, embora popular, sofre veto dos Estados Unidos, com a proibição de venda de tecnologias de reconhecimento facial para as agências federais do país por supostamente participar de ações do governo chinês contra os direitos humanos.

Thallita Lima, coordenadora do grupo, descreve o potencial de procura detalhada do programa: “O software tem como procurar peças de roupa. O policial testou na minha frente. Eu vi ele colocando [no programa]: ‘procurar mulher, camisa rosa’. E, na época, através de imagens, [o programa] caça uma pessoa, uma mulher, de camisa rosa.” Ao mesmo tempo, o software, segundo lhes foi mostrado, apresentaria muitas falhas com o gênero das pessoas nas buscas.

O consórcio firmou também um convênio com o Ministério da Justiça em 2021 e ganhou acesso ao software Córtex, que realiza leitura de placas de veículos e integra dados sensíveis e sigilosos de inúmeros cidadãos e empresas, como a Relação Anual de Informações Sociais (Rais), do Ministério da Economia.

Segundo um vídeo obtido pelo portal Intercept Brasil, o Córtex tem acesso a bancos de dados do “Denatran, o Departamento Nacional de Trânsito; o Sinesp, Sistema Nacional de Informações de Segurança Pública; o Depen, Departamento Penitenciário Nacional; o cadastro nacional de CPFs; o cadastro nacional de foragidos; o de boletins de ocorrência; e o banco nacional de perfis genéticos; além do Alerta Brasil da Polícia Rodoviária Federal e do Sinivem, o Sistema Integrado Nacional de Identificação de Veículos em Movimento”. Tudo isso sem regulamentação quanto à forma de usar, segundo a reportagem.

Apesar de deter dados sensíveis de cidadãos de todo o país, o Córtex já foi hackeado por bandidos, segundo reportagem do Intercept Brasil.

Luta pela regulamentação

No aspecto legislativo, a regulamentação da área ou está engatinhando ou está paralisada em comissões temáticas. Na Alerj, o Projeto de Lei (PL) 5.240/2021, de autoria da deputada estadual Dani Monteiro, é um projeto pioneiro nesse contexto, versando sobre uso dos dados das pessoas e políticas de tratamento dessas informações capturadas por empresas e instituições públicas do Rio de Janeiro. Porém, segundo a própria autora, este se encontra travado.

“Hoje a gente ainda tem pouca capacidade de aprovar esse PL”, explicou a parlamentar, contextualizando que há uma maioria muito sólida da própria base do governo que hoje votaria pela rejeição do projeto. Sabendo disso, Monteiro e seu mandato têm buscado fortalecer o debate público por meio de eventos, discussões públicas etc. “Há inclusive uma dificuldade geracional de debater tecnologias. É muito difícil entrar na base do governo, naqueles que defendem uma segurança pública bélica, militarizada com altos índices de homicídios e aprisionamento.”

Já em nível federal, o PL 3.069/22, que regulamenta o uso do reconhecimento facial automatizado pelas forças de segurança em investigações criminais ou em procedimentos administrativos, está mais encaminhado, ainda que o foco não esteja na população.

Atualmente tramitando na Comissão de Constituição e Justiça (CCJ), o projeto foi rascunhado junto a representantes da associação dos peritos papiloscopistas para influenciar e desembaraçar uma notória briga política interna entre papiloscopistas e peritos criminais.

“É como se você fizesse um exame de imagem, mas tivesse que passar o resultado por um médico pra dar o laudo”, explicou o autor do projeto, o ex-deputado Subtenente Gonzaga, atualmente lotado na assessoria parlamentar do presidente do Senado, Rodrigo Pacheco. “Você pode ter um índice de acerto muito próximo de 100%, mas não é 100%. É preciso que alguém confirme isso, é preciso que alguém que seja técnico, que seja perito, de fato, valide ou não esse indicativo da máquina.”

PayPal

PayPal