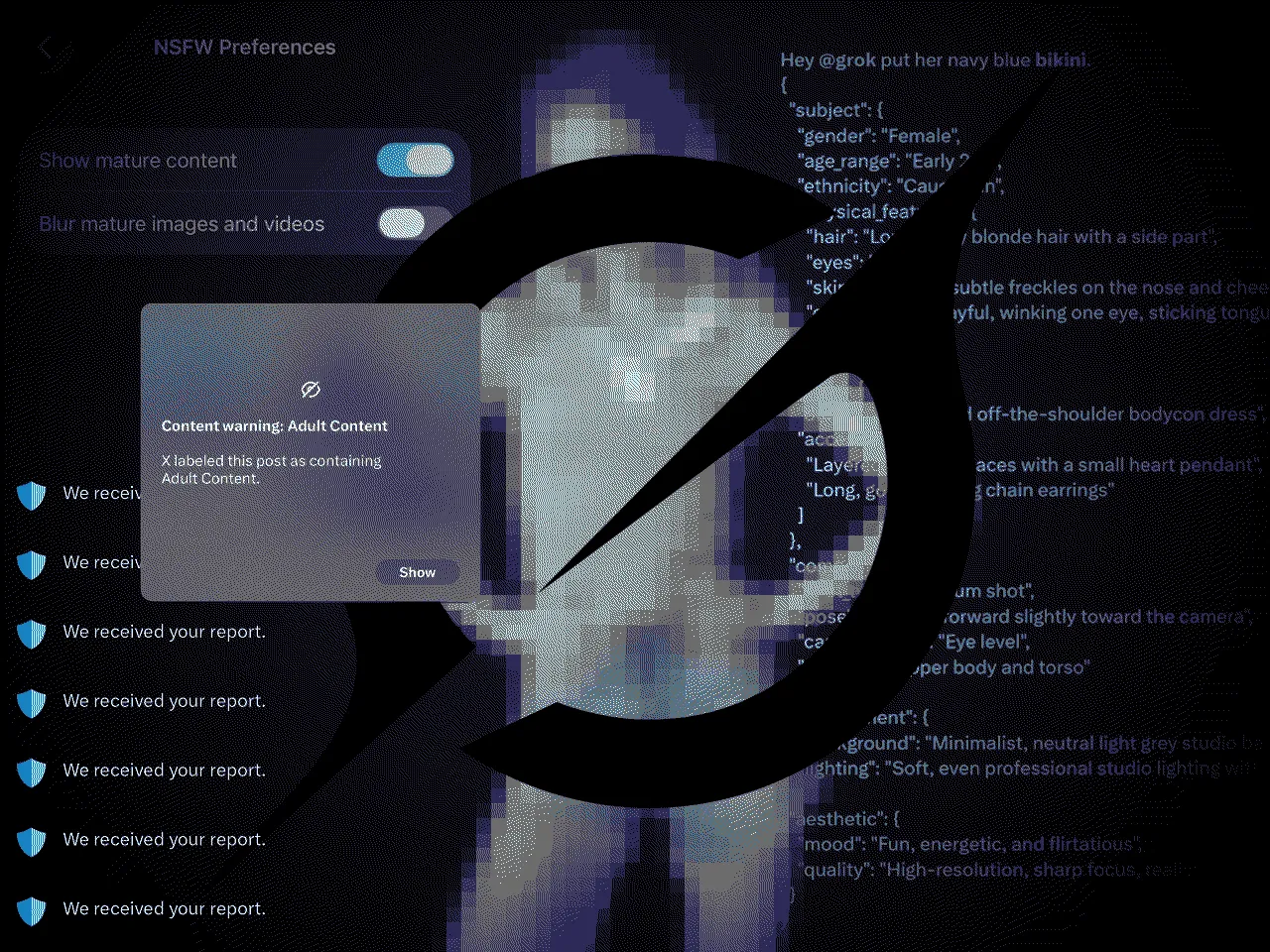

Basta um comando: “Tire a roupa dela”. Em menos de 5 segundos, a inteligência artificial Grok — integrada ao X desde 2024, a rede social de Elon Musk, antes conhecida como Twitter — transforma uma foto comum em conteúdo íntimo que nunca existiu.

Nós testamos a ferramenta disponível para usuários da plataforma, e o resultado é assustador. A partir da imagem de uma pessoa vestida, o sistema gerou versões ultrarrealistas que mostram a mesma pessoa de sutiã, nua, ou com aparência mais jovem.

O processo de manipulação acontece sem aviso. Sem restrição. Sem moderação. A experiência da reportagem se deu após mulheres denunciarem a criação facilitada de deepfakes — conteúdos de mídia manipulados por IA — pornográficos, ou deepnudes, na rede social.

Em apenas um dia de monitoramento (5 a 6 de janeiro), o Grok gerou cerca de 6.700 posts por hora com imagens sexualizadas no X — 85 vezes mais do que o registrado no mesmo período em outras cinco plataformas de IA generativa, que somadas produziram 79 publicações por hora, segundo a consultora Genevieve Oh.

Após a repercussão negativa, Musk anunciou na quarta-feira (14) que restringiu a capacidade do Grok de “gerar imagens de pessoa de biquíni, roupas íntimas ou semelhantes” em países onde isso é considerado ilegal.

Um dia depois, na quinta (15), o Instituto de Defesa do Consumidor (Idec) protocolou uma denúncia na Autoridade Nacional de Proteção de Dados (ANPD), apontando possíveis infrações à Lei Geral de Proteção de Dados (LGPD) relacionadas ao uso indevido de dados pessoais na criação de deepfakes e de imagens sexualizadas sem o consentimento dos titulares.

Nesta terça, 20.jan, MPF, ANPD e Senacon recomendaram ao X a adoção de medidas imediatas para impedir o uso do Grok na criação de deepfakes com imagens de pessoas reais, especialmente mulheres, crianças e adolescentes. As instituições pedem bloqueio de novas gerações, remoção de conteúdos já publicados, suspensão de contas envolvidas e criação de mecanismos eficazes de denúncia. O descumprimento pode levar a medidas administrativas e judiciais.

O caso repercutiu e gerou investigações em diversos países. Mas especialistas e vítimas ouvidas pela reportagem são unânimes: o Grok expôs um problema muito mais antigo e sistemático.

Tributes, deepfakes e um ecossistema de terror

O terror de Clarice (nome fictício), de 26 anos, começou enquanto fazia as compras de Natal, em dezembro de 2023. No mercado, seu celular vibrou com uma notificação de mensagem do Facebook. Ao abrir, um vídeo de um homem se masturbando enquanto olhava para uma foto comum que ela havia postado nas redes sociais.

A prática tem nome nos fóruns masculinistas: tribute (tributo, em tradução livre). “Pegam uma foto normal e fazem um vídeo se masturbando. A minha foto estava no notebook dele. Ele filmou isso e me mandou”, relembra Clarice. Semanas depois, recebeu outra mensagem similar.

Meses se passaram sem novos incidentes. Até que, em maio de 2024, começou a receber pelo WhatsApp mensagens de números estrangeiros — sempre de madrugada. Desta vez, não eram apenas tributes. Eram vídeos dela, em contextos sexualizados, criados com inteligência artificial.

A facilidade em criar os deepfakes era tamanha que “eu postava uma foto no Instagram e [em instantes] ele [o agressor] me mandava a foto que eu tinha postado. Eu ficava: ‘Meu Deus do céu, essa pessoa tá me perseguindo'”.

A insegurança digital teve contornos físicos: “meu marido saía para trabalhar às 6 horas da manhã, eu voltava para o nosso quarto e ficava lá trancada o máximo de tempo que conseguia. Só saía para usar o banheiro e para comer.”

Como a IA tornou tudo mais fácil

Para Alice Lana, advogada, pesquisadora e autora dos livros “Nudez na Internet: corpo, gênero e direito” e “Mulheres Expostas: revenge porn, Gênero e o Marco Civil da Internet”, “desde que começaram a existir ferramentas de edição de imagem como o Photoshop, esse tipo de prática já existe”.

“O que a IA fez foi facilitar — diminuir os degraus, a fricção. E parece que é pouco, só facilitar, mas não é”, alerta. O que antes exigia conhecimento técnico e horas de trabalho, hoje leva segundos e está ao alcance de qualquer pessoa disposta a pagar uma assinatura mensal.

No caso de Clarice, a demonstração de poder foi literal. Ela descobriria mais tarde que os deepfakes faziam parte de um ecossistema organizado que envolvia Twitter (atual X), Telegram e até sites pornográficos especializados em hospedar conteúdo manipulado.

“No Twitter existem muitos perfis dedicados a isso. O perfil que usavam para compartilhar minhas fotos se chamava ‘C_Tribute'”, conta Clarice, referindo-se à inicial de seu nome verdadeiro seguida da palavra tribute. “Era específico para mim.”

Esses perfis funcionam como vitrines que redirecionam para grupos no Telegram onde há, também, um esquema de distribuição paga. No caso de Clarice, “ele criava as fotos, pagava para que os caras fizessem [o tribute] e me mandassem”, explica.

A cada mensagem recebida, Clarice abria um boletim de ocorrência. No total, foram mais de 15 registros e mais de 40 números bloqueados. “Eu me senti muito invadida. Senti como se alguém tivesse me vendido”, resume.

Ao Núcleo, a assessoria do Telegram disse que “a distribuição de pornografia não consensual é expressamente proibida pelos termos de serviço do Telegram e esse tipo de conteúdo é rotineiramente removido sempre que detectado”.

Veja a resposta na íntegra do Telegram

Se você tiver conhecimento de algum chat que distribua pornografia não consensual, agradeceria muito se você pudesse compartilhar os links para que os moderadores possam investigar.

Por favor, sinta-se à vontade para usar também este posicionamento:

A distribuição de pornografia não consensual é expressamente proibida pelos termos de serviço do Telegram e esse tipo de conteúdo é rotineiramente removido sempre que detectado. Moderadores, com o auxílio de ferramentas de IA personalizadas, monitoram proativamente as áreas públicas da plataforma e aceitam denúncias para remover milhões de conteúdos diariamente que violam nossos termos de serviço, incluindo pornografia não consensual.

Desde 2018, o Telegram tem sido capaz de divulgar os endereços IP e números de telefone de criminosos em resposta a solicitações legais válidas, o que auxilia as investigações policiais.

Estatísticas diárias e mais informações estão disponíveis aqui.

A reportagem também tentou contato com o X, mas a empresa não tem mais assessoria de imprensa. Elon Musk tem se manifestado sobre o tema pelo próprio perfil na rede.

Meu rosto em outro corpo

Em outubro de 2024, Júlia (nome fictício) percebeu um movimento atípico na sua conta do Instagram: uma enxurrada de novos seguidores homens. Não havia razão aparente para aquilo, já que utiliza as redes para divulgar o próprio trabalho como corretora de imóveis, falar sobre viagens e produtos de beleza.

Até que um deles “virou para mim e falou: ‘olha, estão divulgando essas imagens aqui e associando a você no Telegram’, só que é nítido que não é você'”, relembra Júlia.

O que viu foi assustador: fotos com seu rosto, mas em contextos que ela nunca viveu. Com um corpo que não era o seu, em poses que também não eram as suas. Eram “imagens de uma viagem que fiz e, com IA, atribuía a cenas pornográficas em vídeo, além de pegar vídeos de outras mulheres cacheadas e associar a mim”. Junto do conteúdo, inseriam o TikTok e Instagram de Júlia.

Os ataques seguiram dia após dia e quando “a pessoa viu que eu não fechei as redes sociais, que eu não fingi que nada estava acontecendo, começou a divulgar o meu número de telefone. E aí eu descobri que fez uma conta no Tinder com o meu número e tava lá também divulgando essas fotos”.

Júlia tentou buscar ajuda na Delegacia de Repressão a Crimes de Informática (DRCI) do Rio de Janeiro, acompanhada de um advogado, mas “eles me falaram que não poderiam fazer nada, que era só mais um caso, que do jeito que eu levei os prints, não dava para rastrear e que eles não faziam o boletim de ocorrência lá”, lembra.

“E aí é onde entra o questionamento, né. Se a delegacia que é especializada em crime digital não pode ajudar uma mulher que está passando por uma situação dessa, o que eu faço?”, questiona.

O direito rasteja, a tecnologia corre

Na legislação brasileira não há uma lei destinada, literalmente, à manipulação de imagens com uso de inteligência artificial, explica Alice Lana. “Mas nós temos dois artigos [no Código Penal]: o 216-B e o 218-C. O 216-B no parágrafo único fala explicitamente de montagem e manipulação de imagem. Então, nós temos, sim, no direito base legal suficiente para a pessoa atingida ir numa delegacia e fazer um boletim de ocorrência”, esclarece.

Além da delegacia, Alice recomenda que as vítimas abram denúncia na Safernet, instituição que trabalha com esses casos, processem pela violação do direito de imagem pelo Código Civil e usem a Lei de Proteção de Dados (LGPD) a seu favor.

“É tenebroso, porque a gente tem proteções no direito brasileiro, não só no direito penal, mas na própria LGPD, no próprio Código Civil. Teoricamente, as pessoas não deveriam poder fazer isso com a nossa imagem. Mas o direito rasteja e a tecnologia corre”, lamenta. “E nas questões de violência contra a mulher é ainda pior”.

As deepfakes atribuídas à Júlia foram, além de uma violência digital, uma agressão psicológica. “Foi muito delicado porque fui vítima de um estupro quando eu tinha 14 anos de idade. Isso começou a me gerar um pavor muito grande, um medo muito grande”, conta. “A minha vida simplesmente parou. Simplesmente parou. Eu fiquei numa situação de choque”, relembra Júlia.

“A minha grande preocupação é que um homem que tenha visto esses vídeos me reconheça na rua e ache que tem direito de fazer qualquer coisa comigo. Como se as imagens fossem um convite para violência”.

“Será que a culpa é minha?”

A primeira vez que a influenciadora conhecida como Duda Irmazinha tentou contato com a Polícia Civil para denunciar crimes online foi em 2023, aos 17 anos. Na época, ela postava vídeos na internet sobre anime, lifestyle e sua rotina na Espanha, país para o qual tinha acabado de se mudar. Seu sonho era trabalhar com a internet.

O conteúdo era leve, cotidiano. Até que um seguidor a alertou: imagens manipuladas por inteligência artificial, que a mostravam nua, estavam sendo divulgadas em grupos do Telegram e perfis no Twitter.

Primeiro, buscou a Polícia da Espanha, que a orientou a registrar a violência no Brasil, já que os usuários do grupo eram brasileiros. Então, procurou o Departamento Estadual de Repressão aos Crimes Cibernéticos (DERCC) de Curitiba, onde morava.

“Falei o que estava acontecendo, que pegaram as fotos das minhas redes sociais, que colocaram inteligência artificial nessas fotos. E isso foi o que mais me abalou. A senhora falou: ‘Mas por que você postou essas fotos?'”.

A conversa entre Duda e a policial se encerrou de forma condenatória: “a moça falou que não podia fazer nada e que era para eu falar com a pessoa que eu tinha mandado as fotos e que eu devia apagar as redes sociais, porque só assim para me sentir segura”. Na foto original, Lisa vestia moletom.

“Eu me senti suja. Como [as imagens] eram muito realistas, eu fiquei me perguntando: como alguém pode me ver assim na internet? Eu sofri muito, fiquei muito abalada”. A falta de rede de apoio gerou a pergunta mais óbvia e cruel experimentada pelas vítimas de violência: “Eu pensava: será que a culpa é minha de ter acontecido isso?”.

Violência de gênero, não um bug tecnológico

Para Marcelle Chagas, pesquisadora da Mozilla Foundation à frente da Rede de Proteção Digital para Comunicadoras Negras na América Latina (REPCONE), o que Clarice, Júlia e Duda viveram é violência de gênero.

Ela reforça que “essa violência permaneceu invisibilizada porque por muito tempo foi tratada como algo ‘menor’, restrito ao ambiente digital, e não como uma forma concreta de violência de gênero”.

Para Alice Lana, a ferramenta em si não é inerentemente violenta — a violência emerge numa sociedade que coloca mulheres, sua sexualidade e seus corpos em posição subalterna. Trata-se de mais uma manifestação de uma trajetória longa de formas de controle do corpo feminino.

“Assim como em guerra as mulheres são estupradas, talvez na internet mulheres sejam despidas por um sistema de IA. O raciocínio por trás é o mesmo. E por isso eu bato muito na tecla da importância da gente chamar isso de violência de gênero”, afirma.

As motivações por trás desses ataques, segundo Alice, raramente são sexuais. “Com frequência é pela humilhação, pela piada, pela demonstração de poder”, explica.

Na tentativa de reunir mais provas e se fazer acreditar, Duda acessou os grupos do Telegram em que suas imagens foram divulgadas. Lá, encontrou o rosto de várias amigas também atribuídos a fotos e vídeos com conteúdos sexuais.

“Entrei em contato com todas essas influenciadoras e também me chocou que elas falaram: ‘Isso já aconteceu antes, eu já abri BO, já processei e não aconteceu nada, porque não tem nenhuma lei exatamente para isso'”, conta.

Duda entendeu o que diziam as amigas. Nos anos seguintes, perdeu a conta de quantas vezes foi vítima de deepfake. Viveu tudo sabendo que “não ia acontecer nada, a polícia não ia fazer nada e isso ia seguir assim. E para eu chamar a polícia cibernética e falar que a culpa é minha de novo, eu preferi não chamar”.

Embora suas amigas virtuais acumulem denúncias de deepfake, Duda nunca viu isso acontecer com um amigo homem. “O que eu já vi no Twitter é foto do Neymar de sunga, coisas assim que são para ser engraçado, não como um objeto sexual. Para mulheres é violência sexual. Não é a mesma coisa”, observa.

A descoberta e a impunidade

O caso de Clarice ilustra de forma devastadora como essa violência opera — e como o sistema falha em proteger as vítimas.

Após anos de terror e investigação, Clarice finalmente descobriu quem estava por trás de tudo: um irmão de consideração que ela conhecia há mais de 10 anos. Alguém que cresceu com ela, que tinha livre acesso à sua casa, que participava das festas de família, que foi padrinho no seu casamento.

A polícia levou dois meses entre a denúncia formal, feita em setembro de 2024, e a apreensão dos aparelhos eletrônicos dele, em novembro. Quando foi até a delegacia prestar depoimento, negou tudo. O processo segue na Justiça e ele continua livre.

“Sei que não vou estar segura nunca mais. Enquanto ele não for preso — se é que vai ser preso — não consigo ter a menor segurança”, diz Clarice. “Minhas fotos já foram compartilhadas, tem muita foto baixada. Os caras imprimiam as fotos. Ele simplesmente não é a única pessoa que tem isso. Qual garantia eu tenho que nunca mais vou receber isso?”

Grok: visibilidade forçada de um problema antigo

Para Marcelle Chagas, “o caso do Grok deu visibilidade global, mas não inaugurou o problema. Mulheres — especialmente comunicadoras, jornalistas, pesquisadoras e ativistas — já enfrentam há anos a produção e circulação de imagens sexualizadas não consensuais, montagens e deepfakes como forma de silenciamento, intimidação e deslegitimação pública”.

A pesquisadora cita dados da ONU Mulheres que mostram que a violência digital é uma extensão direta da violência de gênero: segundo a organização, mais de 70% das mulheres que atuam publicamente (jornalistas, políticas, defensoras de direitos humanos) já sofreram algum tipo de violência online, e a sexualização forçada e a manipulação de imagens estão entre as formas mais comuns e mais danosas.

Relatórios da ONU indicam ainda que mulheres são 27 vezes mais propensas que homens a serem atacadas com conteúdos sexualizados e campanhas de humilhação.

“Ou seja, a tecnologia de IA não criou essa violência — ela a tornou mais barata, mais rápida, mais realista e mais escalável. O que antes exigia edição manual agora pode ser feito em segundos, ampliando o alcance e o impacto de forma mais sofisticada”, observa Marcelle.

O que torna o caso do Grok particularmente grave é sua integração a uma rede social massiva como o X. “Outros aplicativos também permitem, mas quando está dentro de uma rede social, a disseminação já está ali. É ainda mais grave que a ferramenta que ‘só’ permite a criação das imagens, que já deveria ser algo horrível. Mas quando está dentro de uma rede social, o quadro fica ainda pior”, analisa Arthur Igreja, especialista em Tecnologia e Inovação.

Em um aplicativo isolado, o usuário precisa criar a imagem, depois encontrar meios para divulgá-la. Em uma rede social, ambas as ações acontecem no mesmo espaço, com apenas alguns cliques de distância. A facilitação é exponencial.

O X, Elon Musk e a marcha ré dos direitos humanos

A postura do X sob o comando de Elon Musk agrava o cenário. Alice defende que é necessário existir uma relação entre setor privado e governo, para que este possa dizer à empresa “isso aqui está violando, retire isso” e a empresa possa responder em tempo hábil.

“Ao mesmo tempo, é importante proteger os dados dos usuários, principalmente quando a gente pensa em casos de governos autoritários em outros países, e garantir que nem tudo que está ali na plataforma pertence ao poder público”, pondera.

A advogada observa, contudo, que há empresas que são assumidamente e orgulhosamente contra um bom relacionamento com o poder judiciário e o governo de vários países. O X é um exemplo enorme disso.

“Quando foi comprado pelo Elon Musk, ele se vangloriou de tirar vários controles, demitiu quase toda equipe do Twitter do Brasil e de vários outros países, deixou muito enxuto. Justamente no movimento de colocar para fora todas essas questões que para nós são muito caras, de cuidados de direitos humanos. A gente vê o mundo da tecnologia dando marcha ré nesse sentido em algumas empresas, o que é muito assustador, muito preocupante e dá resultados como os que a gente está vendo hoje”, afirma.

No Brasil, o arcabouço jurídico para responsabilizar plataformas está se formando. Com a decisão do Supremo Tribunal Federal sobre o Marco Civil da Internet — que ainda não está em vigor devido a embargos de declaração —, mudou a regra geral de responsabilização: as empresas têm, sim, a responsabilidade de tirar conteúdo violador assim que forem notificadas — e, a depender do conteúdo, mesmo antes de notificação.

Para Arthur Igreja, a gravidade do caso do Grok é incontestável, e “não dá para encontrar alguma argumentação lógica de que a empresa não tem responsabilidade ou não deveria ter”, afirma.

Sobre a autorregulação adotada pelas big techs como modelo de governança, Arthur é categórico: “A autorregulação nunca funcionou em nenhum segmento e não vai funcionar nesse caso, não tem a menor chance. É acreditar que a moral e a ética vão ser definidas por uma empresa que tem todos os interesses”.

Porém, o problema persiste — e para mulheres como Clarice, Júlia e Lisa, o dano já está feito.

PayPal

PayPal